中金 | 机器学习系列(2):强化学习模型轮动框架下的行业配置

作者:中金量化及ESG

题图:中金量化及ESG微信公众号

摘要

我们在机器学习系列第一篇报告《机器学习系列(1):使用深度强化学习模型探索因子构建范式》中使用强化学习模型生成因子表达式,所挖掘的因子在样本外有效性较为显著。本篇报告作为机器学习系列报告的第二篇,我们将回归强化学习的优势领域:组合优化任务。

我们将深度强化学习模型应用到行业配置(行业轮动)中,充分发挥强化学习在序列决策任务上的优势,让强化学习模型选出可能具有相对优势的行业。在尝试了多种创新性训练方法以避免模型的过拟合等关键问题后,我们发现使用强化学习模型轮动的训练框架可以最终得到兼顾稳定与收益的结果。公众号内容为报告原文节选,获取原报告请联系分析师或相应销售老师。

强化学习的优势领域:组合优化

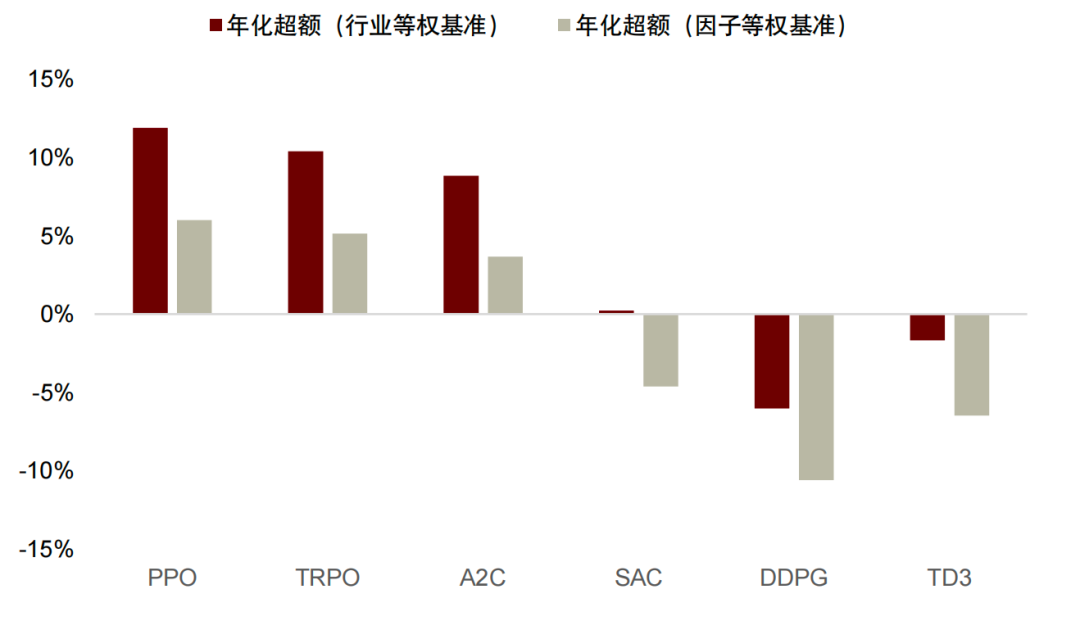

我们认为强化学习相较于其他传统机器学习模型而言,与环境交互更新策略的方式使其更加适用于序列决策任务,这使得其与多为时序类型的金融数据更加匹配。我们使用强化学习模型在金融领域较为经典的FinRL框架,全面梳理并测试PPO、TRPO、SAC、A2C、DDPG和TG3六大主流强化学习模型在行业配置上的表现。

单次训练模式:缺乏确定性的收益

由于机器学习尤其是强化学习的高复杂度,模型稳定性一直是业界较为关注的议题。我们首先使用单次切分的方法把样本数据以2022年1月为界划分成样本内外。在样本内进行模型训练,在样本外验证其有效性。我们发现周频调仓下相对于行业等权和因子等权来说,两年期样本外分别获得11.9%和6.0%的年化超额收益,但并不是所有随机数种子的样本外都可以达到这一理想结果。

在对其稳定性进一步测试时,我们使用了不同强化学习模型、超参数、随机数种子以及不同样本区间起点等条件测试其对于训练效果的影响。我们发现训练敏感性方面:模型选择>样本区间>随机数种子>关键超参数。以上不同选择带来的超额收益率极差可达20%以上。因此单次训练模型面对的样本外不稳定风险是我们接下来主要解决的问题。

平衡收益与风险:拓展搜参vs模型轮动

为了缓解模型的不稳定性,我们尝试拓展训练超参搜索和模型滚动两种方法对模型进行更新训练。两种方式都确保模型能够及时接受最新的市场数据,实验表明模型轮动的思路更好地兼顾了稳定性与高收益。

我们首先使用拓展训练的模型,固定每一期样本内长度,样本外数据则采用外推半年的方法确定,下一期样本内截止时间依次推后半年。在每一期样本内的训练中我们引入Optuna框架寻找最优参数,将样本内最优的参数组合及模型应用于当期样本外。拓展训练结果显示相对于单次训练的平均效果并没有太明显的超额收益,尤其是在因子等权超额的角度来看,和单次训练差距不大。

而使用滚动模型框架时我们测试得到在因子等权和行业等权的超额收益对比单次训练的样本外平均水平都有了显著提升。模型滚动框架相对行业等权样本外年化超额收益16.4%,相对于因子等权年化超额收益7.7%。稳定性方面,在多次滚动中模型战胜等权基准的胜率均达到100%,表现也显著优于单次训练的结果,效率上并行训练方案也比搜参方案平均提升超过5倍。

► 风险提示

模型基于历史数据构建,未来可能存在失效风险。

正文

深度强化学习算法应用到行业配置任务

面向时间序列金融场景的深度强化学习模型

近年来随着人工智能技术的日益兴起,深度强化学习被大量应用到了围棋、游戏和自动驾驶等序列决策场景。在金融领域类似的场景以资产配置/组合优化任务为主。例如,Liu等人在2021年提出的FinRL框架,首次将前沿的强化学习算法系统应用到了资产配置任务中,并开源了对应的算法框架;Ye等人在2020年提出的SARL模型, 增加资产信息与价格变动预测作为额外的状态,该预测可以仅基于财务数据(例如资产价格)或利用新闻等替代来源的资产数据。也有部分研究在因子挖掘及合成任务上取得了突破性的进展。如我们在机器学习系列第一篇报告《机器学习系列(1):使用深度强化学习模型探索因子构建范式》中使用强化学习模型生成因子表达式的思路,将原论文改进后所挖掘的因子在样本外有效性较为显著。本篇报告作为机器学习系列报告的第二篇,我们将回归强化学习的优势领域:组合优化,并将其应用到行业配置任务中。

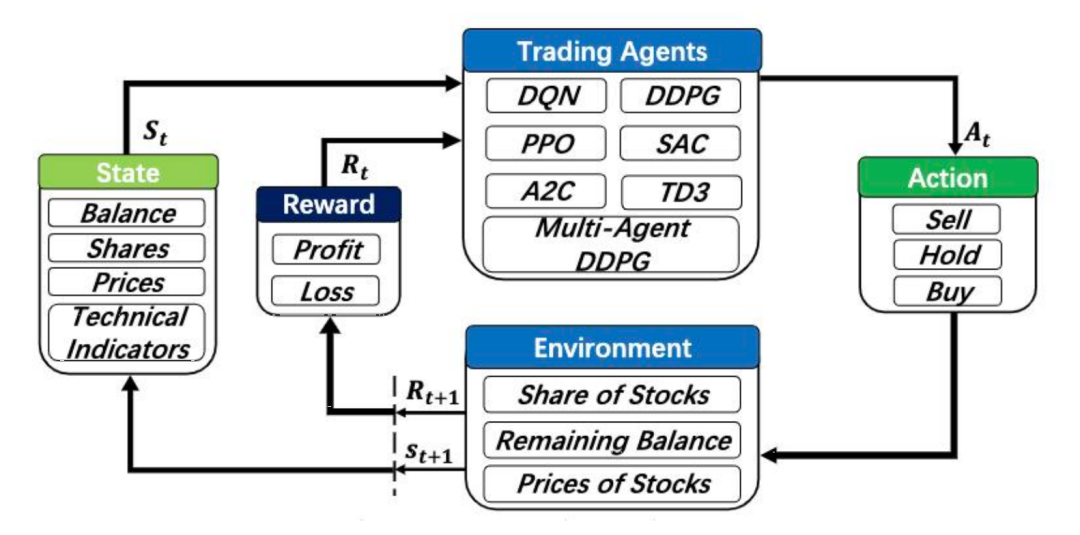

图表1:FinRL 整体框架

资料来源:FinRL: Deep Reinforcement Learning Framework to Automate Trading in Quantitative Finance. Xiao-Yang Liu. 2021

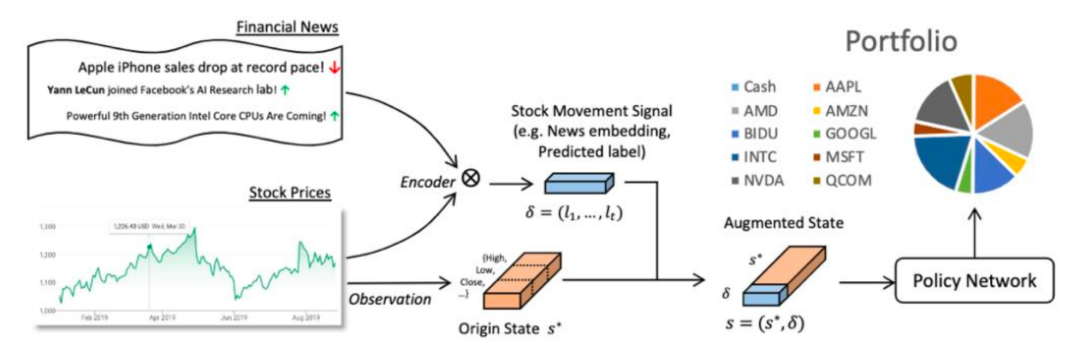

图表2:SARL整体框架

资料来源:Reinforcement-Learning based Portfolio Management with Augmented Asset Movement Prediction States. Yunan Ye. 2020

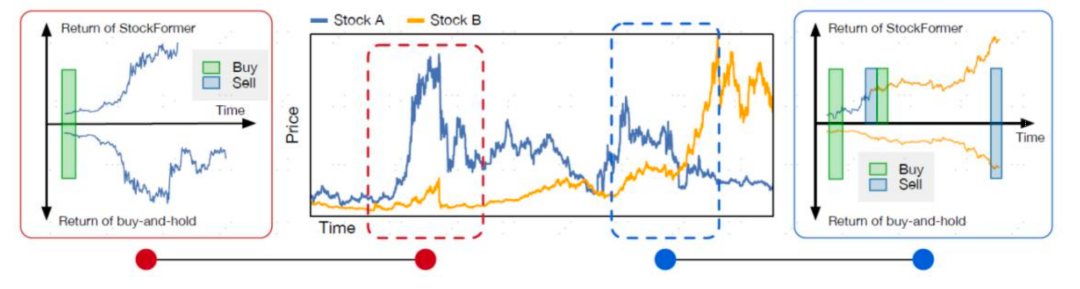

强化学习在资产配置任务取得如此广泛应用的一个主要原因在于其在序列决策任务上的灵活性。以股票交易场景为例,相较于固定策略在给定窗口的起始和结束时间分别执行买和卖的交易行为,强化学习策略能够更灵活的选择卖点以获取更高的收益;此外,当存在多只股票时,相比固定策略只会挑选一只股票进行投资,强化学习模型可以更灵活的进行调仓,即图示中先买入股票A,而后调仓买入股票B,使整体收益最大化。

图表3:强化学习交易策略相比固定策略在资产配置任务上的优势

资料来源:StockFormer: Learning Hybrid Trading Machines with Predictive Coding. Siyu Gao. 2023

序列决策任务建模流程与主流算法介绍

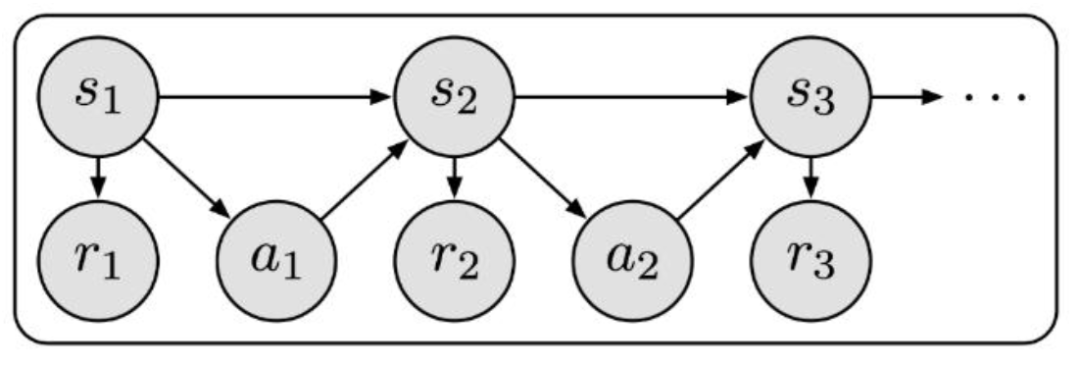

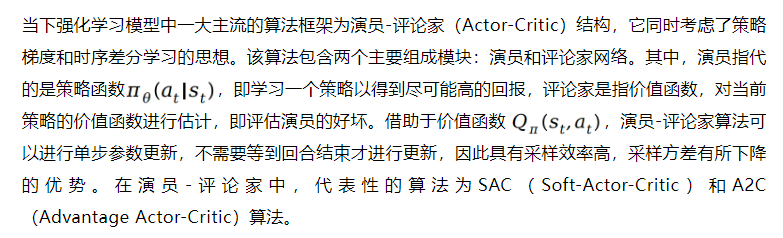

我们在《机器学习系列(1):使用深度强化学习模型探索因子构建范式》提出强化学习具有四个特点:1.适合处理序列决策任务;2.输入数据无需遵从独立同分布的假设;3.通过与环境交互探索来不断优化当前策略;4.数据无需具备标签。针对行业序列决策任务,我们训练强化学习智能体与市场环境进行交互,这个交互过程可以通过马尔可夫决策过程进一步展开说明。当下主流的强化学习算法框架为演员-评论家算法(Actor-Critic),代表性的模型包括SAC和A2C与PPO,它们也是本篇报告行业配置预测框架所使用的主要方法。

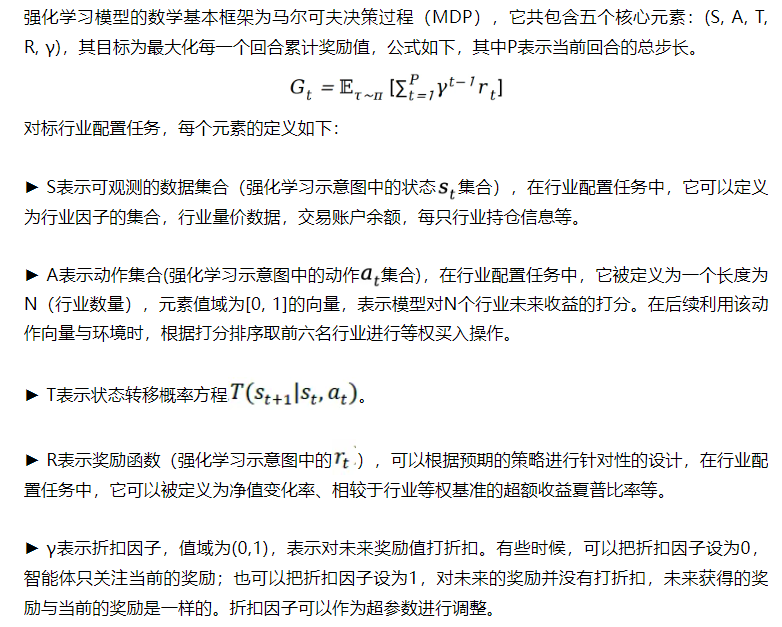

马尔可夫决策过程

图表4:马尔可夫决策过程示意图

资料来源:“StockFormer: Learning hybrid trading machines with predictive coding.” Siyu Gao等(2023)

演员-评论家(Actor-Critic)结构

图表5:演员-评论家算法在行业配置任务中的流程图

资料来源:StockFormer: Learning Hybrid Trading Machines with Predictive Coding. Siyu Gao. 2023

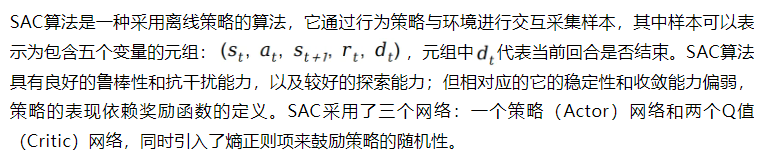

SAC算法

A2C算法

A2C算法是一种采用在线策略5的算法,具有训练速度快和提升整体策略稳定性的优势,在小型环境中表现良好。与之对应的,模型不一定能够找到最优策略;且由于每次更新都需要进行新的采样,模型对样本的利用效率较低。除了与 SAC 相似的策略优化和价值函数学习的核心思想,A2C 算法的独特贡献在于提出了优势函数(A),它的数学表达式为:A=Q-V。优势函数表示的是在当前状态下执行某个动作的价值(Q)与该状态平均价值(V)的差异,有助于提高模型的效率和稳定性,减少策略网络的数值差异。

A2C 算法的核心思想是使用两个网络:一个是策略网络(Actor),另一个是价值网络(Critic)。Actor:生成动作的概率分布,根据当前状态选择动作。Critic:评估当前状态的价值,用来衡量动作选择的好坏。

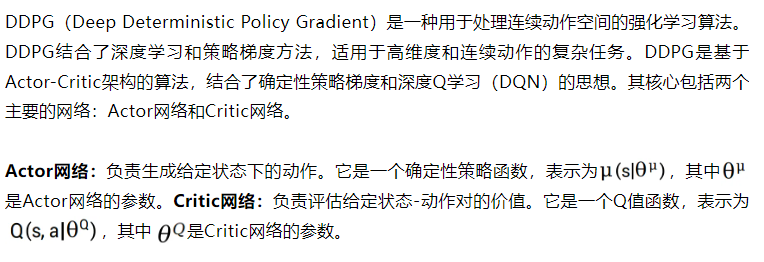

DDPG算法

TD3算法

TD3(Twin Delayed Deep Deterministic Policy Gradient)是对DDPG(Deep Deterministic Policy Gradient)算法的改进版本,用于处理连续动作空间的强化学习问题。TD3通过引入几种关键改进来解决DDPG中的一些问题,如过估计偏差和不稳定性。TD3的核心思想在于通过使用双重Critic网络、目标策略平滑和策略延迟更新等技术,来提高学习的稳定性和性能。

TD3中的 Actor 网络和目标网络更新的频率低于Critic网络。这意味着Critic网络在Actor网络更新前会多次更新,从而提高Critic网络的准确性。通常,Critic网络在每个时间步更新,而Actor网络每隔固定的步数(例如每2个时间步)才更新一次。TD3能够处理高维度的连续动作空间,适用于机器人控制、自动驾驶等领域。TD3的这些改进使其在需要高精度和稳定性的连续控制任务中表现优异。

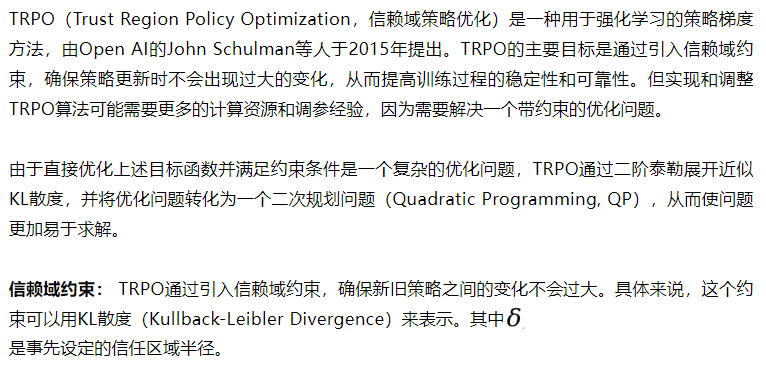

TRPO算法

PPO算法

PPO(Proximal Policy Optimization,近端策略优化)是一种强化学习算法,仍由Open AI的John Schulman在2017年提出。PPO是TRPO的改进版,它保留了TRPO的核心思想,但通过简化约束优化问题,使算法更易于实现和计算效率更高。PPO使用了“剪辑”方法来限制策略更新的大小,从而确保策略在更新过程中不会发生过大的变化。以下是PPO算法的原理和核心内容:

Trust Region方法:PPO受到了Trust Region Policy Optimization(TRPO)算法的启发,但与TRPO不同的是,PPO通过一种更简单的方式来实现类似的效果。TRPO通过解决一个复杂的优化问题来限制策略更新的范围,而PPO则采用了更简单且易于实现的剪辑方法。相比于TRPO,PPO更易于实现和调试。适用于大规模和高维度的强化学习问题。

单次训练模式:缺乏确定性的收益

强化学习模型以序列决策任务见长,但同时模型收益性和稳定性的权衡也是备受讨论的话题之一。尤其是在金融领域,如果收益的稳定性无法保障,那么回测出来的高收益曲线也只是空中楼阁。本文将在这一章首先提出强化学习模型在时序数据预测或者组合优化任务中的一般框架:从数据的处理到模型的构建再到模型表现的测试。

在对其稳定性进一步测试时,我们使用了不同超参数、随机数种子以及不同样本区间起点等数据测试其对于模型的影响。我们发现模型敏感性方面:模型选择>样本区间>随机数种子>关键超参数。以上不同选择带来的超额收益率极差可达20%以上。因此单次训练模型面对的样本外不稳定风险是我们主要面对的问题。

强化学习预测时序数据基础框架

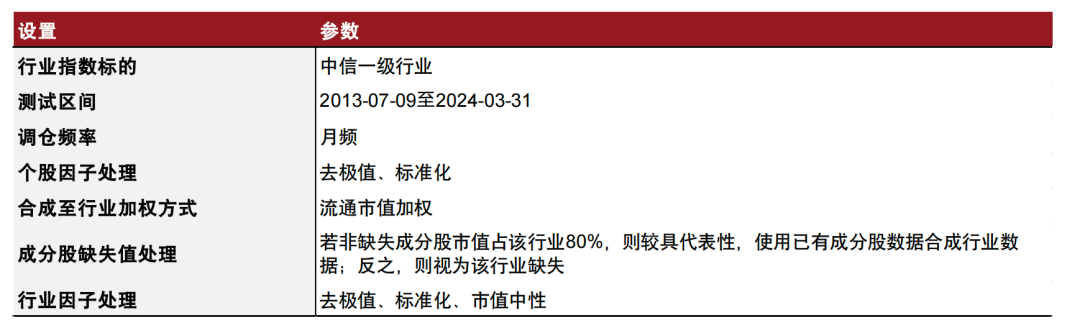

数据集构造

本文采用中信一级行业作为行业配置任务的数据来源。考虑到模型收敛对样本量的需求,删除历史数据长度较短的综合金融(CI005030.WI)行业,保留其他29个行业。根据下图所展示的有效行业价量及基本面因子,将数据集的长度范围定义为2013/07/09-2024/03/31,根据所采用的具体训练模式决定训练集和测试集的划分节点。其中,训练集的样本数据用于训练模型参数,而测试集数据则用于检验模型样本外表现及策略稳定性。

我们使用中金量化及ESG团队开发的因子库中的因子作为模型的输入数据。中金量化及ESG因子库现存有数百个较低相关的核心因子,包含价量、基本面、另类数据和高频数据因子共11类。具体因子构建方式及表现见《量化多因子系列(12):高频因子手册》、《另类数据策略(2):如何优化新闻文本因子》、《量化多因子系列(7):价量因子手册》和《量化多因子系列(5):基本面因子手册》。

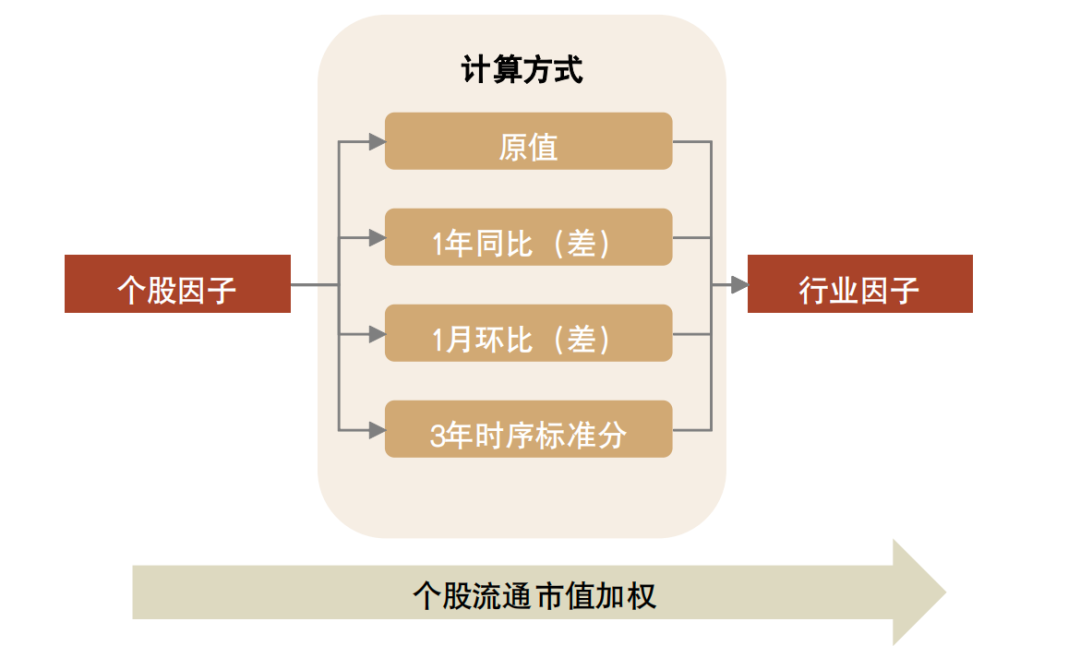

我们沿用了《行业轮动系列(4):轮动节奏自适应行业轮动2.0模型》的方法,将中金价量和基本面因子从个股层面以下述方式合成至行业层面,对因子全时点有效性进行了测试。对于每种因子,我们测试了因子原值以及基于原值的3种变化构建方式,分别为年同比(差分)、月环比(差分)和3年时序标准分。我们在每一类因子中选取行业层面ICIR最高的因子一共11个,作为深度强化学习模型的输入数据。

图表6:行业因子合成方法参数

资料来源:中金公司研究部

图表7:因子合成变化构建方式

资料来源:中金公司研究部

图表8:入选行业因子测试结果

注:1)统计时间为2013-07-09至2024-03-31;2)调仓频率为月频;3)超额收益的比较基准为中信一级行业等权基准

资料来源:Wind,中金公司研究部

预测框架基础设定

本文采用如下两个对照基准与强化学习模型的策略进行比较,并采用三个指标对策略性能进行评价:年化收益率、夏普比率和最大回撤。

►行业等权基准:采用与强化学习模型相同的交易策略等权买入29个行业。

►因子等权基准:采用与强化学习模型相同的输入因子和交易策略。结合因子方向,计算11个因子求和后的得分,选择得分排名最高的六个行业等权买入。

单次训练模式:收益与风险并存

单次训练:以PPO模型为例

本节强化学习模型首先采用单次训练模式,侧重于数据集的静态使用,模型训练效率较高。我们将数据集范围中的2013/07/09-2021/12/31定义为训练集,2022/01/04-2024/03/31定义为测试集,并选择当下主流的强化学习算法PPO(Proximal Policy Optimization)模型作为实验的切入点。该方法在TRPO算法的基础上通过引入剪切机制限制策略更新幅度,有效降低了原有方法的复杂性,具有稳定性高、实现简单以及样本利用率高等优势。

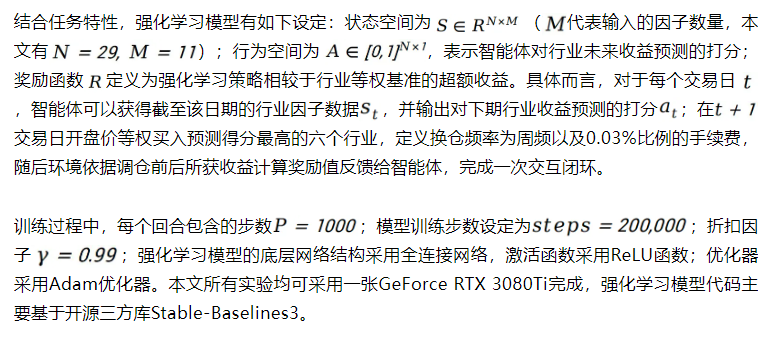

图表9:PPO模型超参设定

资料来源:FinRL: Deep reinforcement learning framework to automate trading in quantitative finance.Xiaoyang Liu. 2021,中金公司研究部

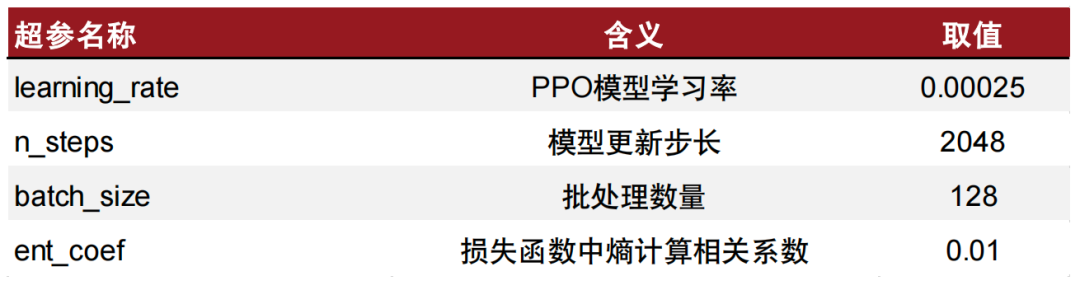

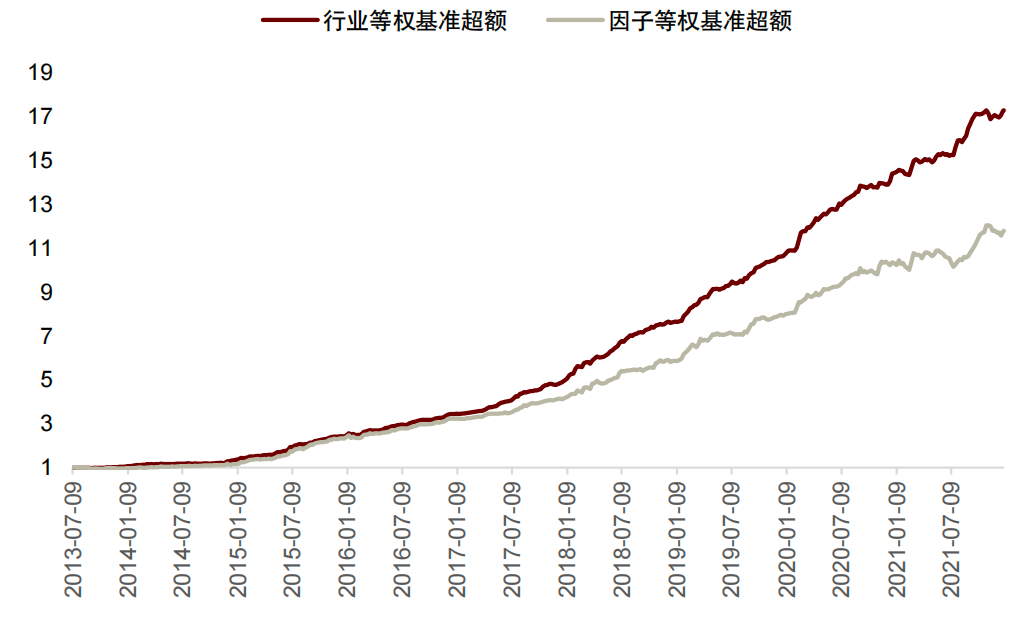

全样本回测结果表明PPO模型输出的策略具有较为有效且稳定的超额收益。与行业等权基准相比,模型策略具有持续为正的超额收益:2023年的超额收益率和夏普比率分别为17.18%及2.488。与采用同样输入数据的因子等权基准相比,PPO模型在大多数年份中具有正向的超额表现,2023年的超额收益率及夏普比率为9.98%和1.246。上述实验现象说明如下两点结论:

►筛选得到的因子组合在周频的行业配置任务下依然能够稳定的战胜行业等权基准;

►同样输入的情况下,PPO模型优化的策略相比因子等权基准策略具有更好的收益表现。

图表10:PPO模型相较于两等权基准方法分年度性能表现统计

注:1)统计时间为2013-07-09至2024-03-31;2)2013-2021为训练集样本区间,2022-2024为测试集样本区间;3)调仓频率为周频

资料来源:Wind,中金公司研究部

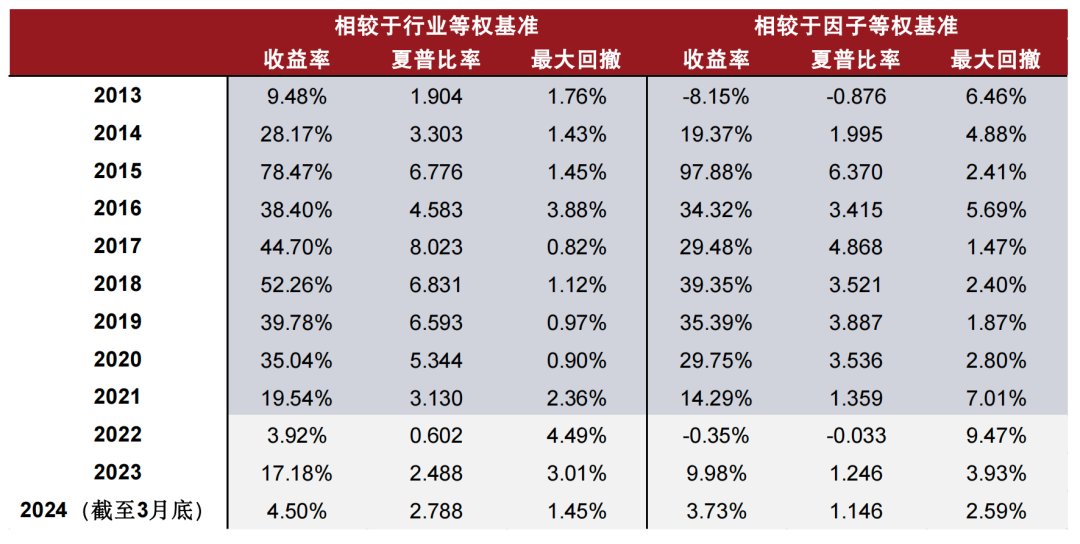

图表11:PPO模型样本内超额净值收益曲线

注:1)统计时间为2013-07-09至2021-12-31;2)调仓频率为周频;3)超额收益的比较基准为行业等权基准和因子等权基准

资料来源:Wind,中金公司研究部

图表12:PPO模型样本外超额净值收益曲线

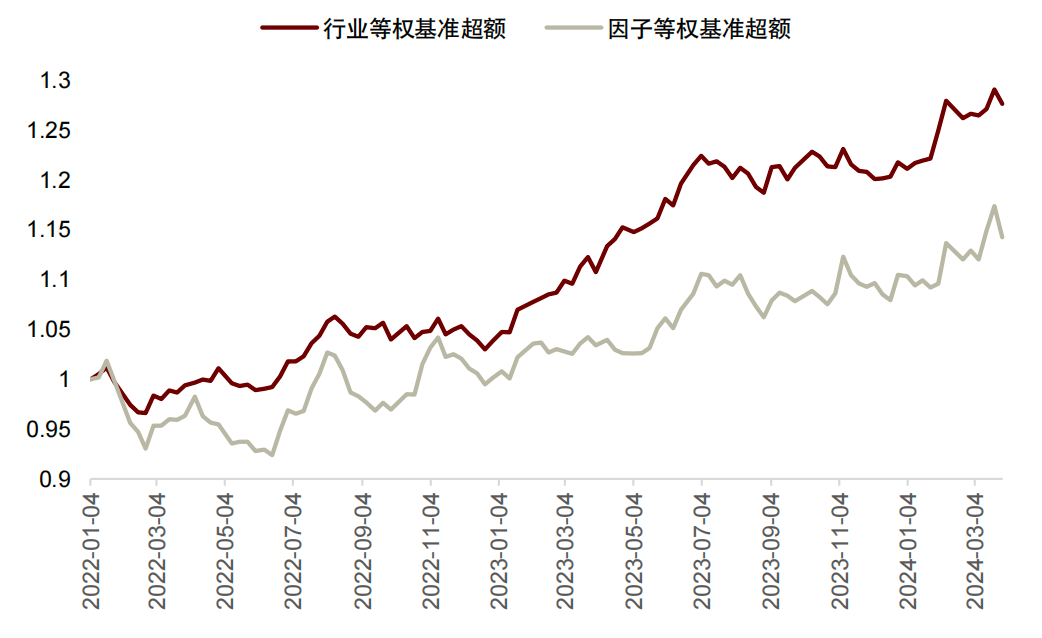

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)超额收益的比较基准为行业等权基准和因子等权基准

资料来源:Wind,中金公司研究部

兼顾收益和稳定性的调仓策略:周频

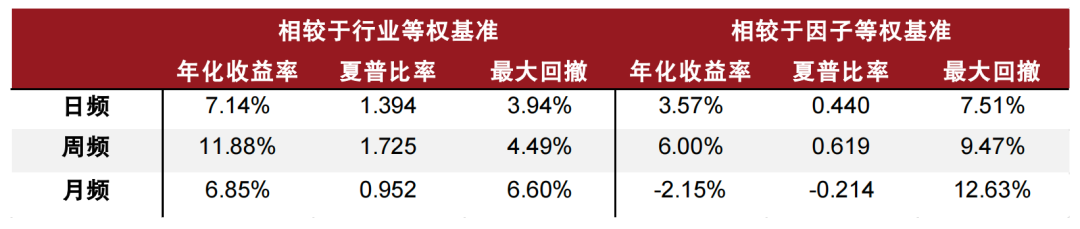

我们以日频、周频和月频作为调仓周期训练PPO模型,根据样本外回测表现可以发现:采用日频调仓策略得到的强化学习模型相较于行业等权和因子等权基准均具有不错的超额收益,然而它面临高达71.96%的换手率,不具有实操性。而采用月频调仓策略得到的强化学习模型性能则无法战胜因子等权基准,我们认为这是由于数据利用率过低导致模型未能收敛。综合比较,采用周频调仓策略的模型则能够较好的兼顾模型的收益性(均优于行业等权基准和因子等权基准)和稳定性(换手率为16.96%),故本报告中将行业配置任务的调仓频率定义为周频。

图表13:PPO模型采用不同交易频率训练后样本外回测表现

注:1)统计时间为2022-01-04至2024-03-31;2)日频调仓周期为1个交易日,周频调仓周期为5个交易日,月频调仓周期为20个交易日

资料来源:Wind,中金公司研究部

强化学习的敏感性测试:模型选择、随机数种子、超参数与样本空间

本节将主要就强化学习模型在单次训练模式下的稳定性进行更为深入探讨,包括强化学习模型的选择、PPO模型对超参选择的稳定性、以及对样本区间的敏感性检测。

强化学习模型的选择

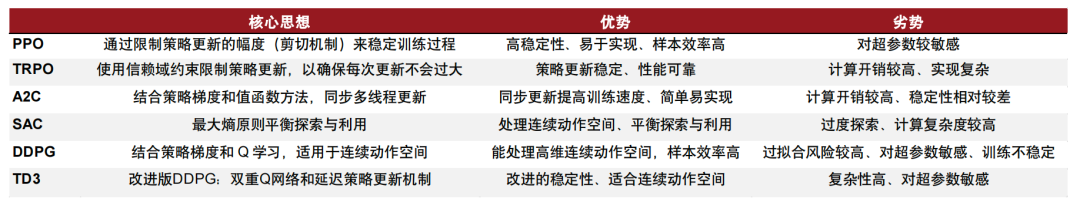

考虑到本文所处理的行业配置任务连续动作空间的特点,我们选择了六类主流的强化学习算法进行比较:PPO、TRPO、A2C、SAC、DDPG和TD3。与强化学习模型建模解决的多数任务相比,本文的任务依赖于有限长度的行业日频历史数据,因而模型自身的结构复杂度将会成为是否过拟合的核心因素。

图表14:主流强化学习算法核心思想及对比

资料来源:Wind,中金公司研究部

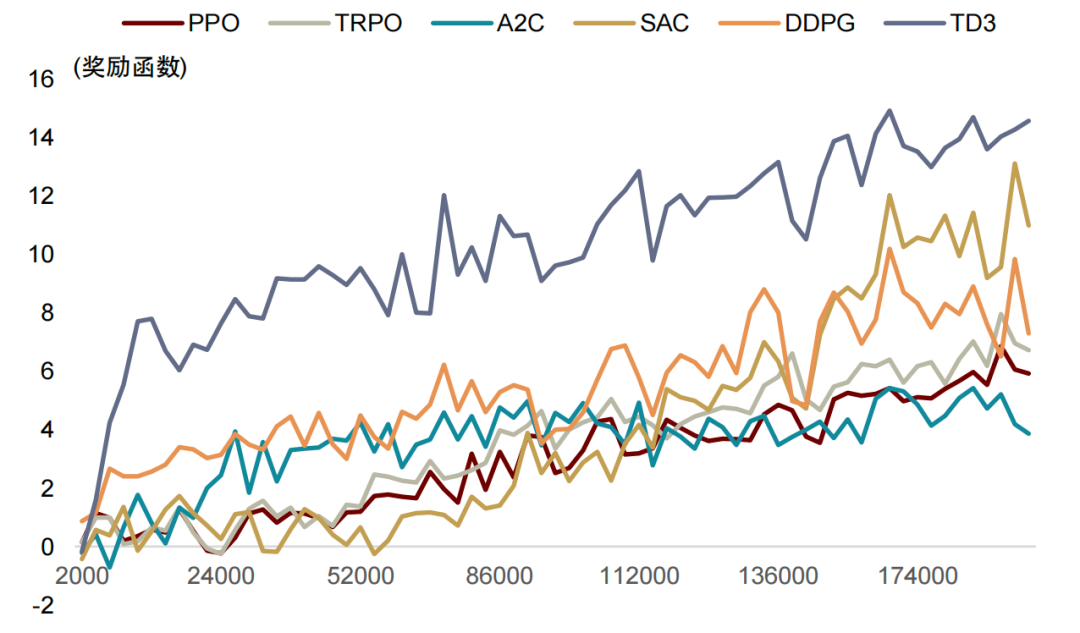

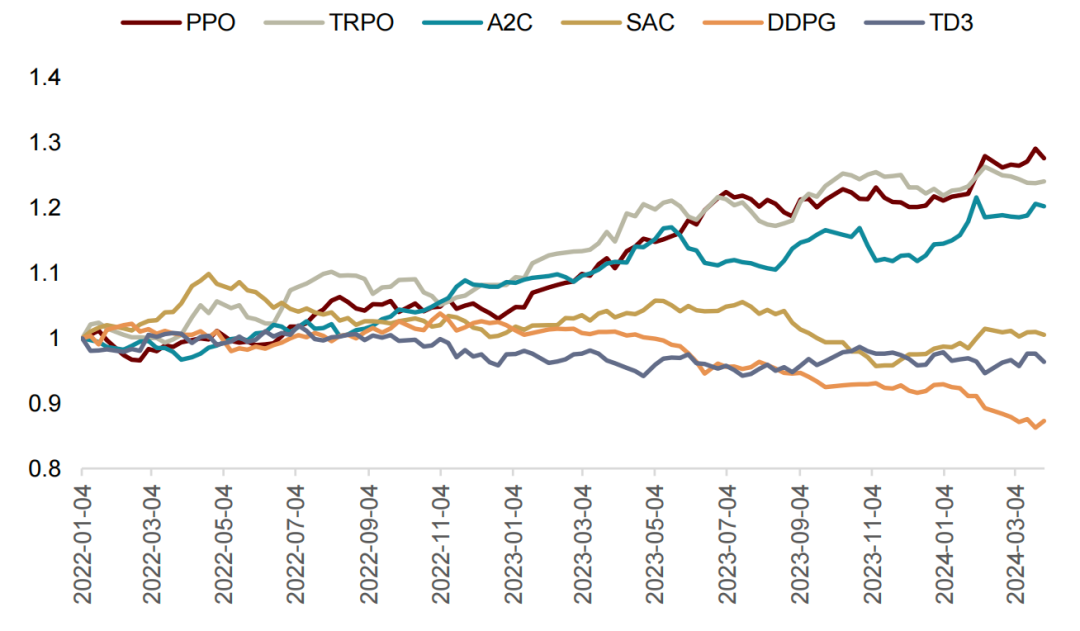

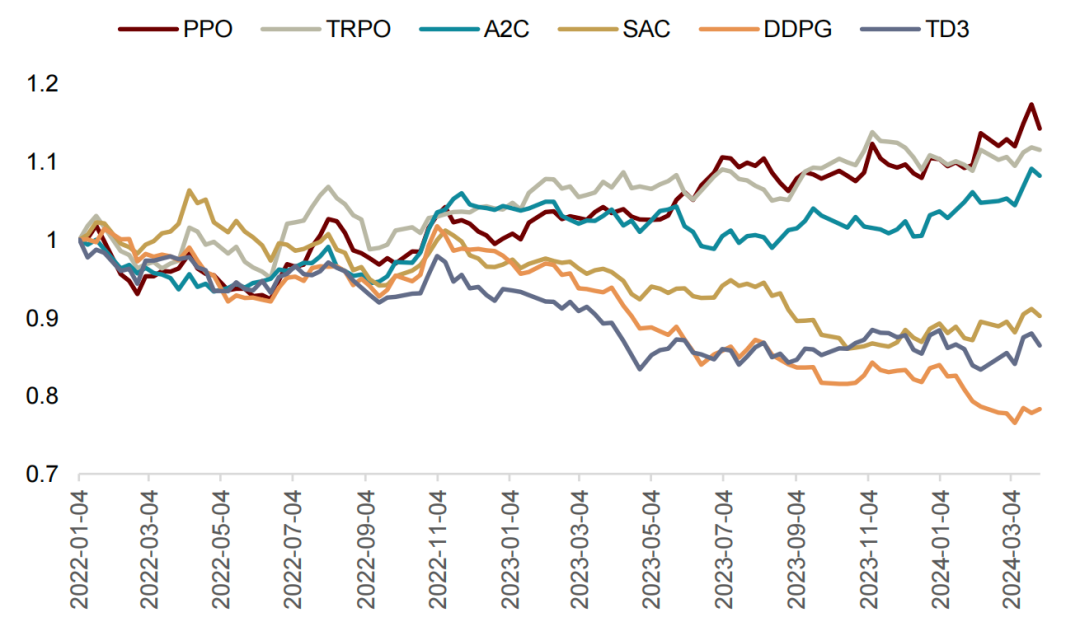

PPO、TRPO及A2C模型具有优于行业等权基准及因子等权基准的样本外收益表现;相比之下,SAC、DDPG和TD3模型输出的策略在样本外的表现则不尽如人意。进一步结合训练阶段的奖励函数变化曲线,TD3、DDPG及SAC模型在样本内都学习到了获得较高回报结果的策略,可以推测:上述三类模型很大概率产生了过拟合。结合强化学习模型特点,我们认为有如下三方面原因:

►模型复杂度:SAC、DDPG和TD3的模型复杂度较高,在处理训练数据量较为有限的行业配置任务时更容易发生过拟合。

►探索和利用的平衡:SAC模型强调高探索性,虽然在训练中将有助于发现更优的策略,但也有可能导致模型在训练数据中陷入某些特定的模式,从而在样本外数据中失效。

►超参调整:DDPG模型对超参非常敏感,尤其在数据量较少以及噪声较大的情况下更容易产生过拟合。

图表15:不同强化学习模型奖励函数随训练变化曲线

注:1)横坐标为训练步数,纵坐标为对应回合内每步奖励函数值的平均值;2)奖励函数曲线采用0.6的权重值进行平滑;3)强化学习模型均使用单次训练结果及周频调仓频率;4)所有强化学习模型训练长度均为200,000步

资料来源:Wind,中金公司研究部

图表16:不同强化学习模型样本外超额收益表现

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)强化学习模型均使用单次训练结果;4)所有强化学习模型训练长度均为200,000步

资料来源:Wind,中金公司研究部

图表17:不同强化学习模型相较于行业等权基准样本外超额收益净值曲线

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)强化学习模型均使用单次训练结果

资料来源:Wind,中金公司研究部

图表18:不同强化学习模型相较于因子等权基准样本外超额收益净值曲线

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)强化学习模型均使用单次训练结果

资料来源:Wind,中金公司研究部

PPO模型对随机初始化及超参的稳定性

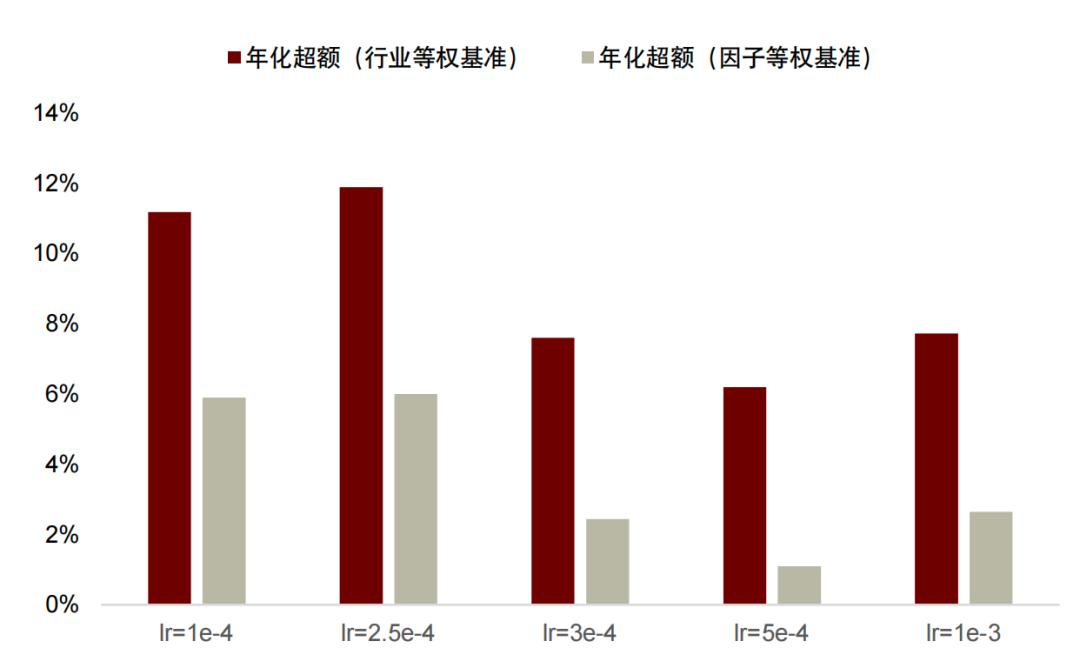

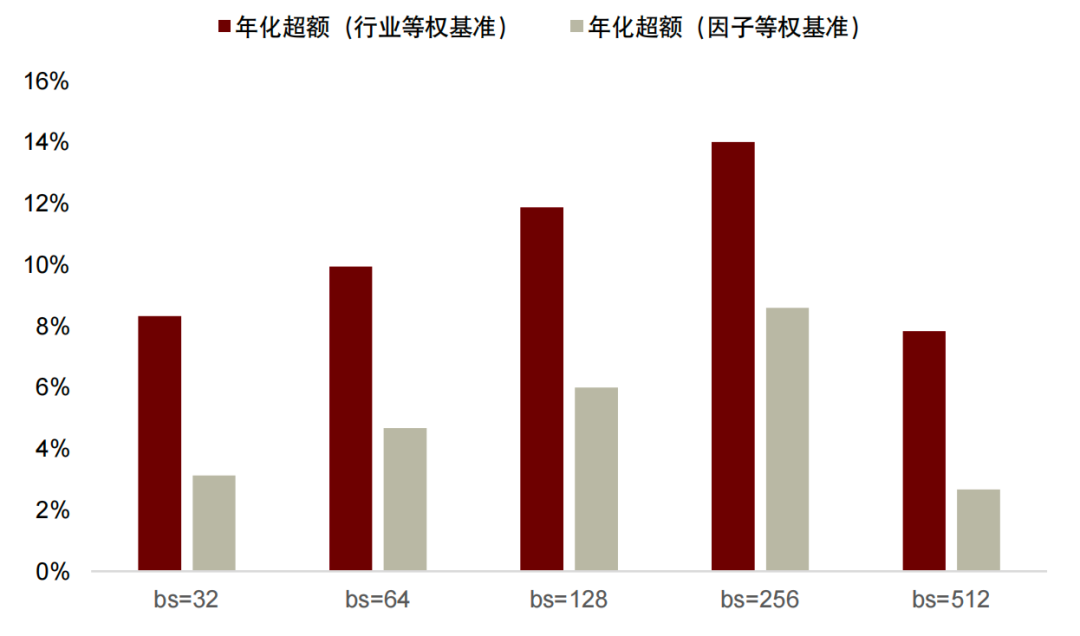

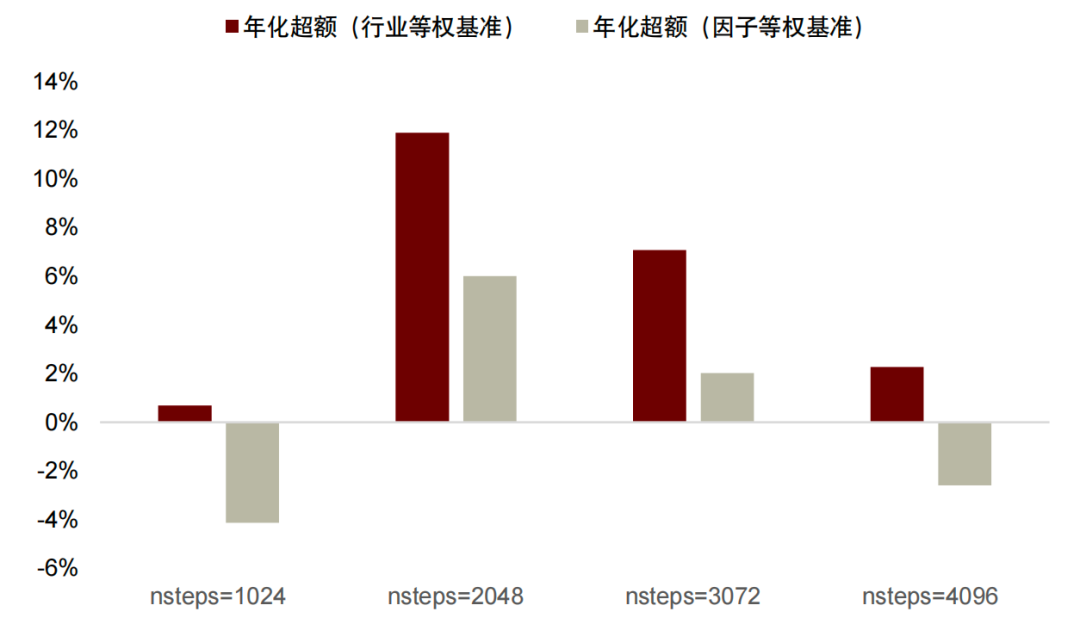

根据上一节的测试结果我们本节进一步测试PPO的超参数敏感度与随机数种子敏感度问题。我们发现PPO对于学习率、batch_size、nstep以及随机数种子均有一定敏感性。其中模型样本外表现对于batch_size和nsteps的变化规律为先升后降,可能存在一个理论最优参数。对于学习率来说则无明显规律,或是学习率选择范围过窄所致。

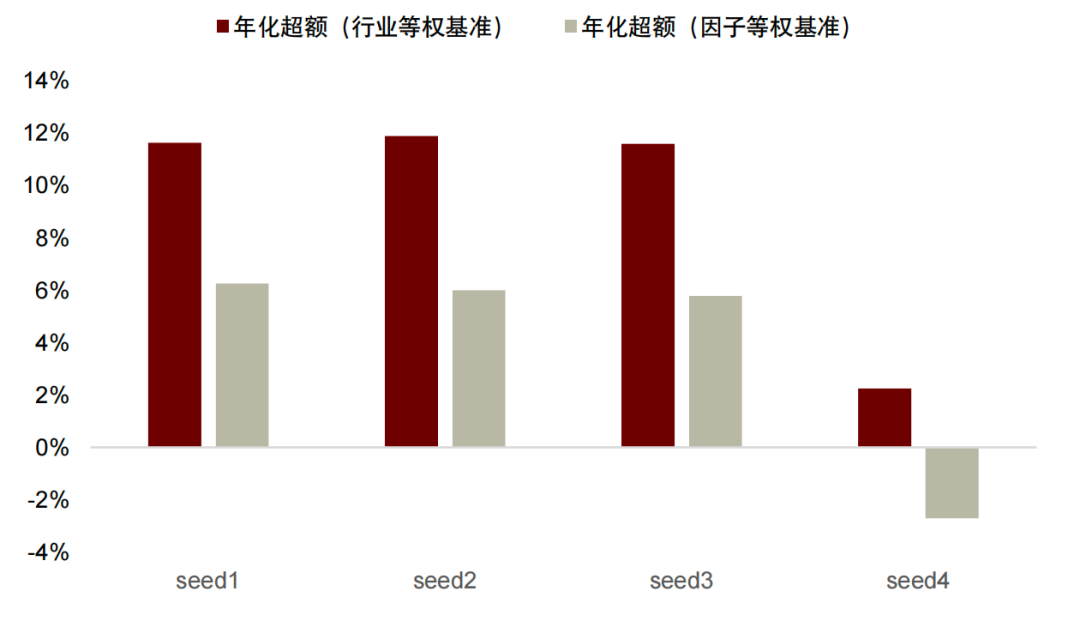

由于强化学习模型训练过程存在较高的随机性,我们采用四个不同的随机数种子初始化PPO模型的参数以验证其在行业配置任务下训练的稳定性。如图表22所示,在前3个随机数种子的初始化下,PPO模型训练得到的策略在样本外具有较为稳定的超额收益表现,但同样该方法也存在随机初始化造成模型策略样本外回测表现较差的情况。即模型具有不同初始状态时,使用同样的数据训练大部分都可以保持基本一致的样本外表现。但仍不排除有些随机数种子的选择仍会影响模型最终表现的情况(图表22,seed4)。

图表19:PPO模型样本外表现随学习率变化趋势

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)PPO模型仅使用单次训练结果

资料来源:Wind,中金公司研究部

图表20:PPO 模型样本外表现随 batch_size 数量变化趋势

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)PPO模型仅使用单次训练结果

资料来源:Wind,中金公司研究部

图表21:PPO 模型样本外表现随单次更新步数大小变化趋势

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)PPO模型仅使用单次训练结果

资料来源:Wind,中金公司研究部

图表22:PPO 模型样本外表现随不同随机数种子变化趋势

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频

资料来源:Wind,中金公司研究部

对于机器学习模型来说,当模型足够稳定时,理论上来说模型的初始化无法对模型的样本外表现造成影响。出现上述情况时,可能是PPO模型自身的特点导致的不稳定。此外不同超参数亦会对模型的表现有显著影响,因此我们在下一节尝试引入Optuna调参框架,希望能让模型随着输入时间序列数据的不断更新尽快调整。

图表23:不同随机初始化的PPO模型相较于行业等权基准样本外超额收益净值曲线

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)PPO模型使用不同随机数初始化参数进行4次训练获取平均结果;4)虚线为4次训练标准差波动

资料来源:Wind,中金公司研究部

图表24:不同随机初始化的 PPO 模型相较于因子等权基准样本外超额收益净值曲线

注:1)统计时间为2022-01-04至2024-03-31;2)调仓频率为周频;3)PPO模型使用不同随机数初始化参数进行4次训练获取平均结果;4)虚线为4次训练标准差波动

资料来源:Wind,中金公司研究部

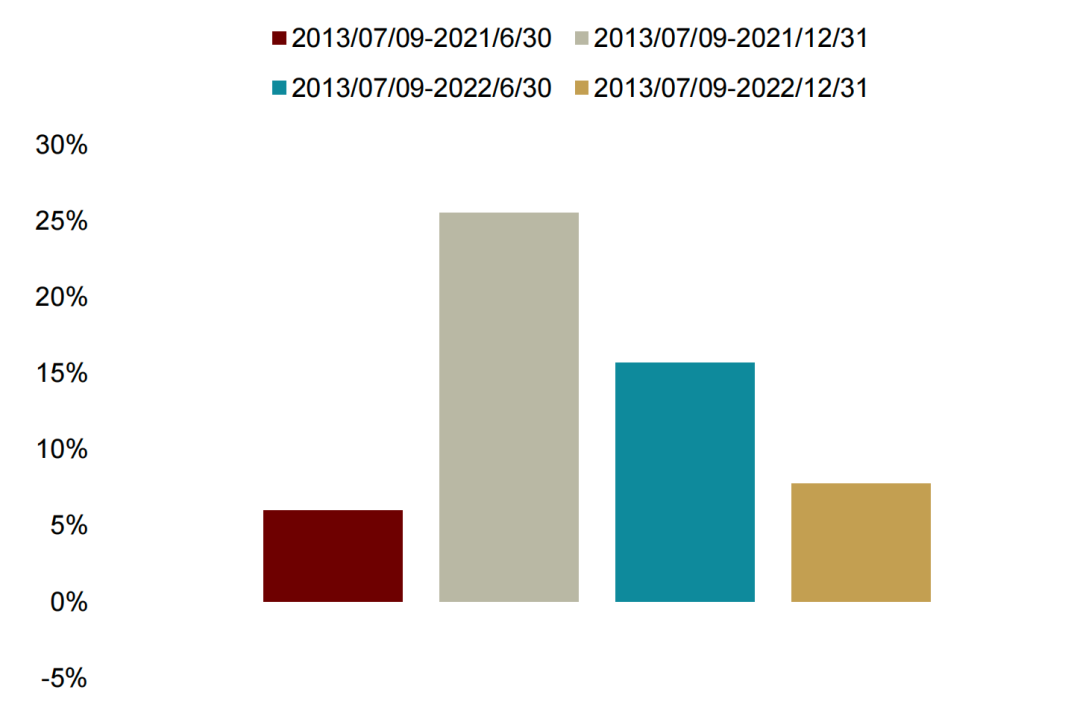

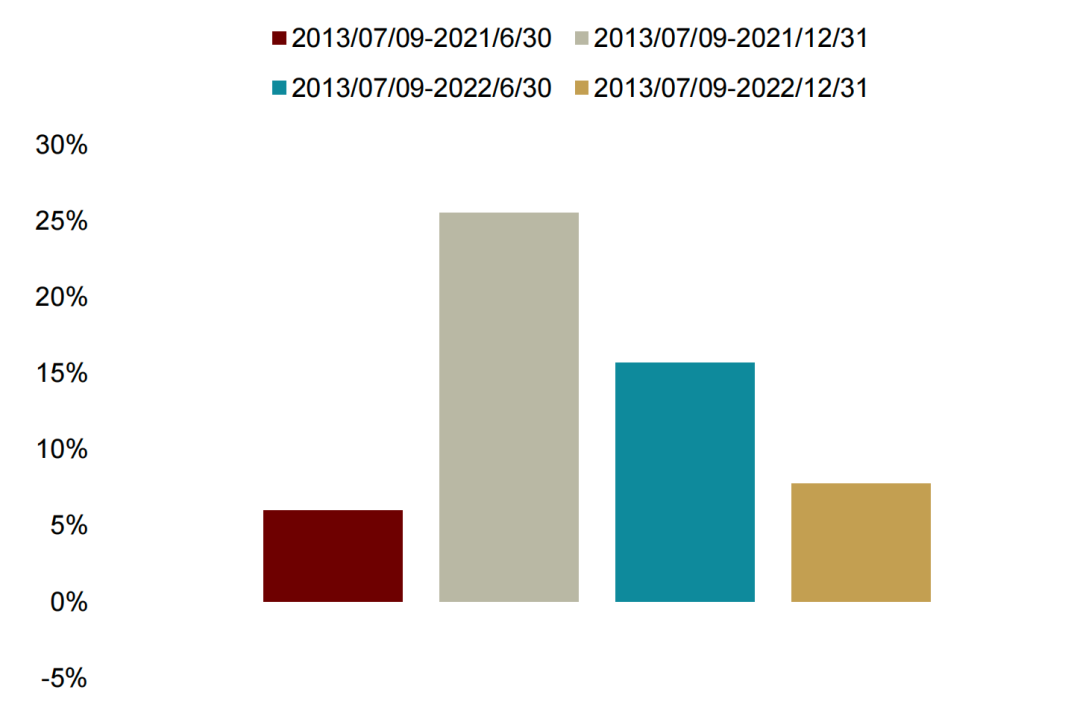

样本区间的敏感性检测

我们设定了四种不同的训练集结束时间(2021-06-30,2021-12-31,2022-06-30,2022-12-31)对PPO模型分别进行训练,并使用2023-01-01至2024-03-31范围的数据测试模型输出策略在样本外的表现。以2023年为例,使用不同范围训练集优化得到的策略在样本外存在较大的表现差异,具体体现在:以2021-06-30和2022-12-31作为训练集截止点得到的强化学习策略无法战胜因子等权基准,表明强化学习模型对于以行业配置任务为代表的金融时序决策任务上训练区间设定较为敏感。使用PPO测试发现不同区间训练集相较于行业等权超额最大可相差接近20%。

在我们的机器学习系列报告第一篇我们发现强化学习模型表现会在较大程度上受到超参数、随机数种子等因素的影响。在本篇报告中的测试结果显示除上述因素外强化学习模型还很有可能受到训练样本区间选择的影响,且在不同强化学习模型中都可能出现这个问题。我们认为这种结果不只来源于某单一模型的不稳定性,而是这种固定样本区间的训练框架合理性也需要重新讨论:当模型的输入样本并没有包括到某一特定历史时期的数据时,模型在样本外将很难对其做出反应。这使得我们需要重新审视强化学习模型与金融数据结合训练的方式。

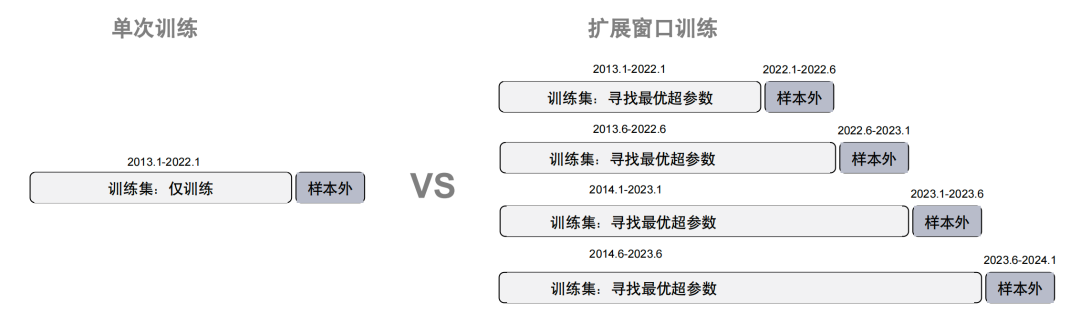

基于以上的考虑,我们将在下一章尝试动态训练框架。目前行业主流的动态训练框架有拓展搜参、滚动搜参和滚动模型轮动等训练思路。我们希望通过尝试上述思路,使得模型可以自适应对金融数据的不同时期的特点及时做出调整。

图表25:PPO模型使用不同区间训练集相较于行业等权基准样本外超额收益统计对比

注:1)样本外表现的统计时间为2023-01-01至2024-03-31;2)调仓频率为周频;3)PPO模型未调参,不同的训练集超参均一致

资料来源:Wind,中金公司研究部

图表26:PPO模型使用不同区间训练集相较于因子等权基准样本外超额收益统计对比

注:1)样本外表现的统计时间为2023-01-01至2024-03-31;2)调仓频率为周频;3)PPO模型未调参,不同的训练集超参均一致

资料来源:Wind,中金公司研究部

平衡收益与风险:拓展搜索vs模型轮动

适应性拓展训练框架一方面保证模型尽可能接触到更能描述市场全景的数据集,另一方面在训练中灵活寻找适合当前数据环境的超参数。在拓展训练框架中,我们每隔半年更新一次模型以及超参数,使用接下来的半年数据作为样本外环境对其加以验证。

图表27:单次训练与拓展窗口训练在训练集划分方式上的对比

资料来源:中金公司研究部

Optuna参数搜索框架

Optuna是一个开源框架,用于自动化机器学习超参数优化,旨在使优化过程更高效、灵活且易于使用。它通过定义一个目标函数来评估不同的超参数组合,用户可以通过定义搜索空间来指定需要优化的超参数及其取值范围。Optuna使用Tree-structured Parzen Estimator (TPE) 贝叶斯优化算法,高效地搜索超参数空间,并支持随机搜索和网格搜索等传统方法。此外,Optuna 支持并行和分布式计算,可以在多台机器上同时进行超参数搜索,加快优化过程。它提供了试验管理工具,记录每次试验的超参数组合及其结果,便于用户比较和分析。Optuna 还提供多种可视化工具,帮助使用者直观地理解超参数搜索过程和结果,包括优化历史和参数重要性分析。

拓展样本训练:位获得显著优势

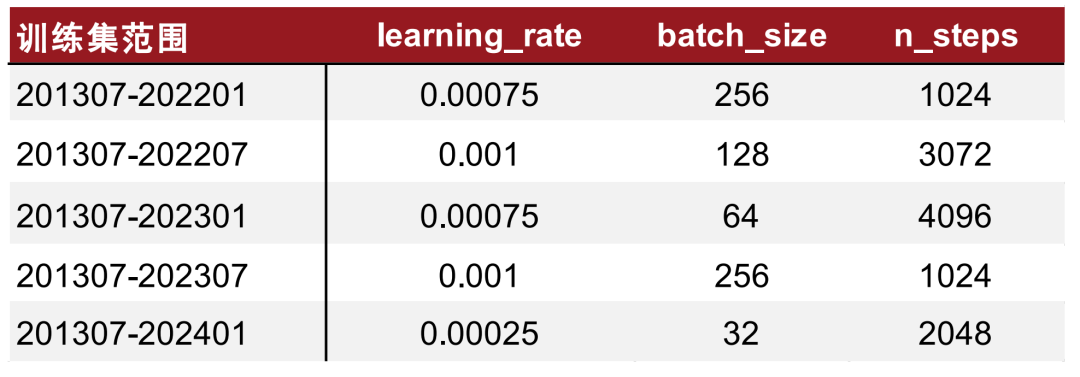

我们在每次训练模型的同时寻找最优超参数,对于PPO模型来说相对比较重要的超参有学习率、模型更新步长和批处理数量。

图表28:Optuna调参范围

资料来源:Wind,中金公司研究部

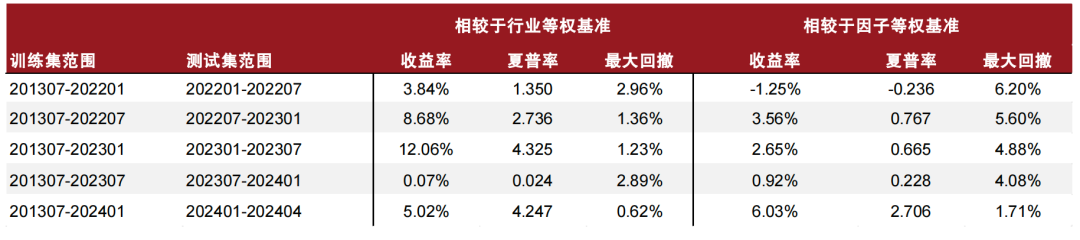

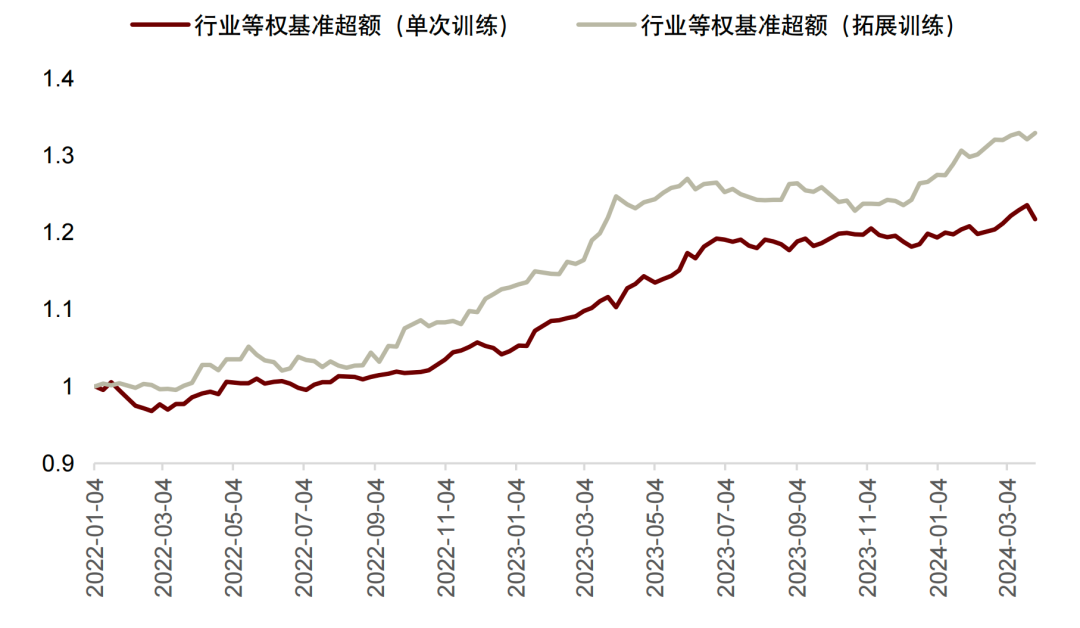

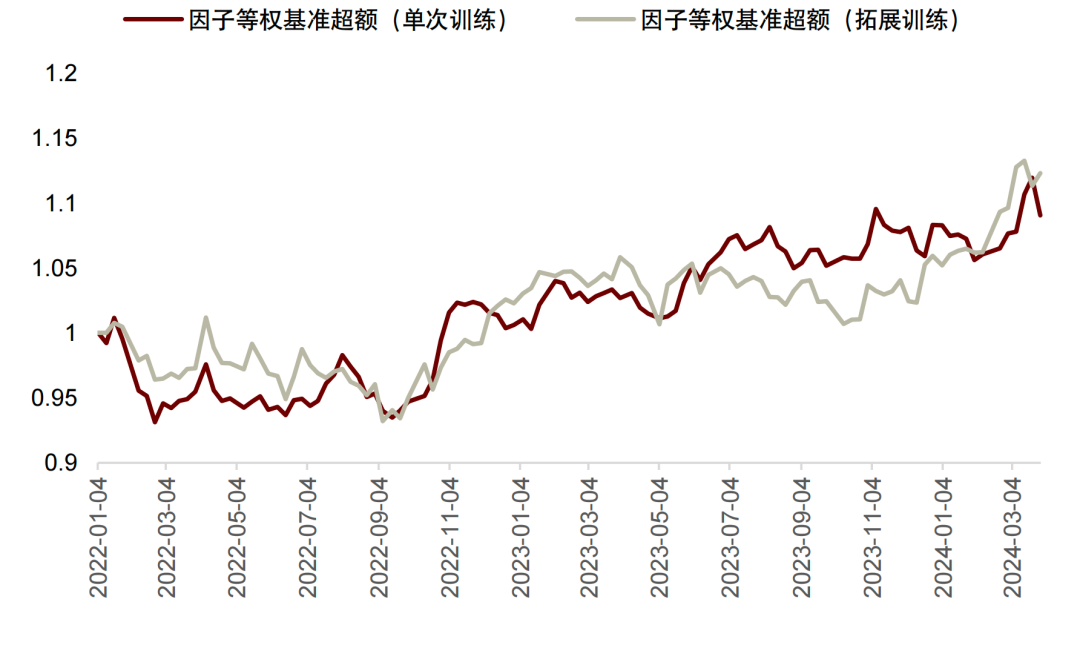

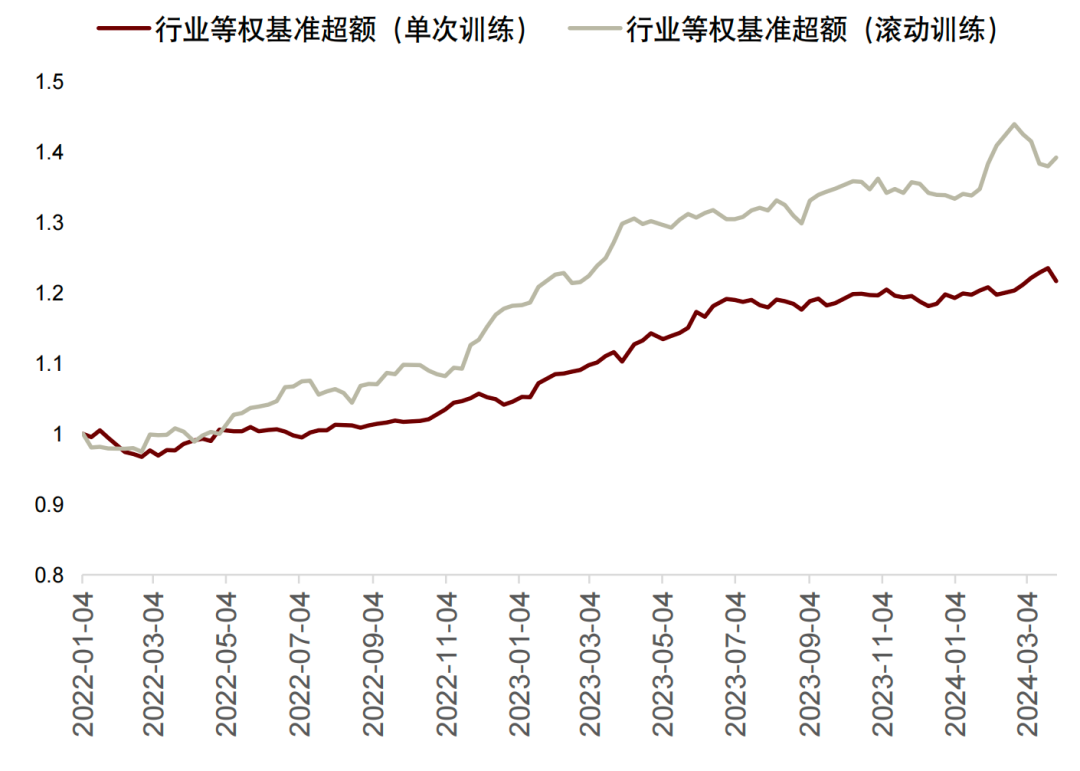

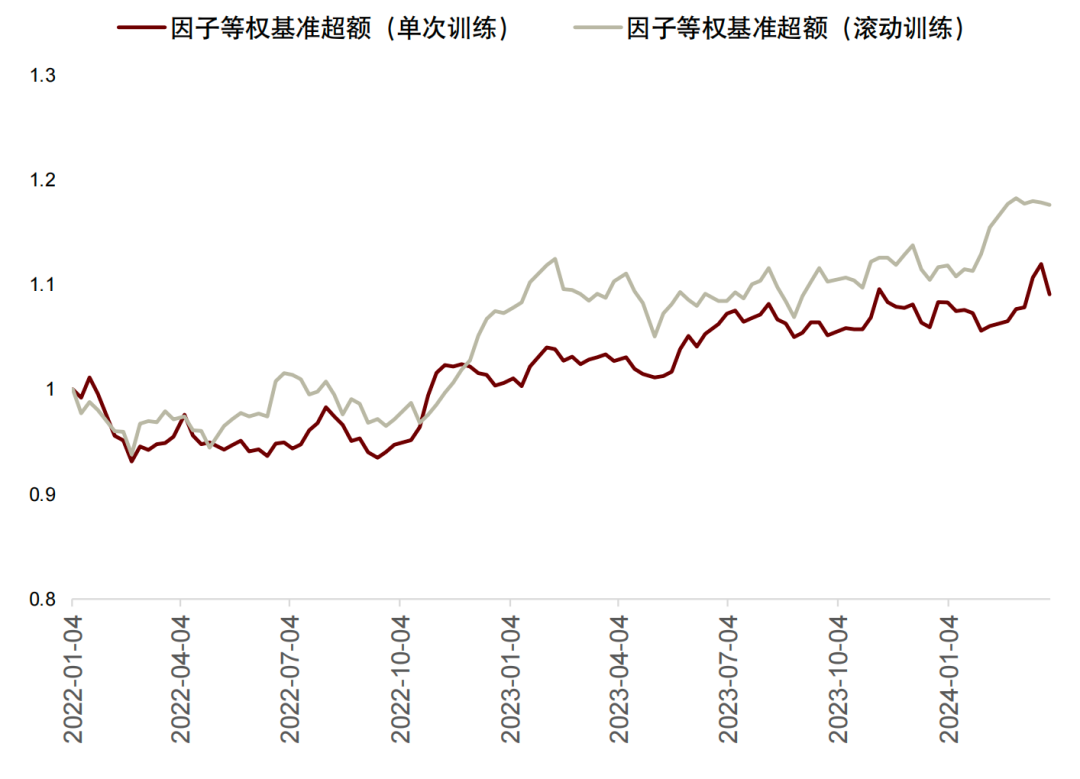

我们发现在多次滚动更新模型时,模型表现相对单次训练有一定优势。尤其是对行业等权的超额收益来说,净值曲线明显可以跑赢单次训练的超额收益。

图表29:适应性拓展训练样本外回测表现统计

资料来源:Wind,中金公司研究部

图表30:不同训练模式样本外相较于行业等权基准超额收益净值曲线

资料来源:Wind,中金公司研究部

图表31:不同训练模式样本外相较于因子等权基准超额收益净值曲线

资料来源:Wind,中金公司研究部

图表32:Optuna调参结果统计

资料来源:Wind,中金公司研究部

强化学习轮动:收益与稳定的全面提升

拓展训练的方式虽然让我们在对行业等权的超额更有优势,但对比因子等权的表现仍不明显。我们因此考虑《Deep Reinforcement Learning for Automated Stock Trading: An Ensemble Strategy》的思路,尝试在不同的阶段使用不同的强化学习模型,希望找到不同强化学习模型适配的市场环境。

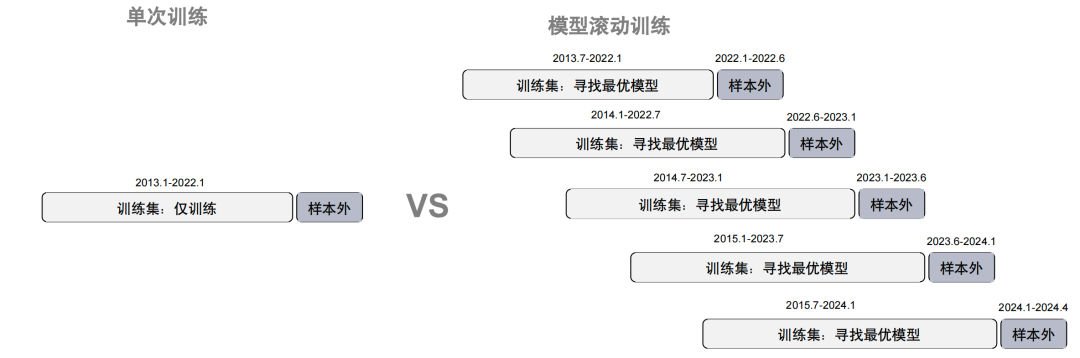

图表33:单次训练与滚动模型训练在训练集划分方式上的对比

资料来源:中金公司研究部

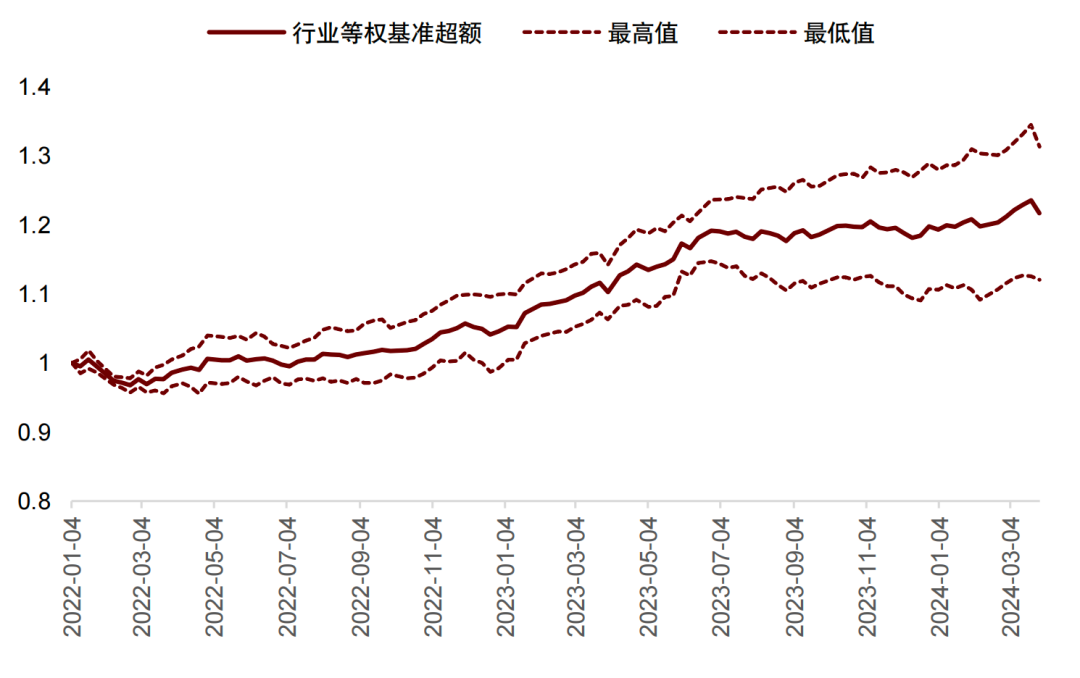

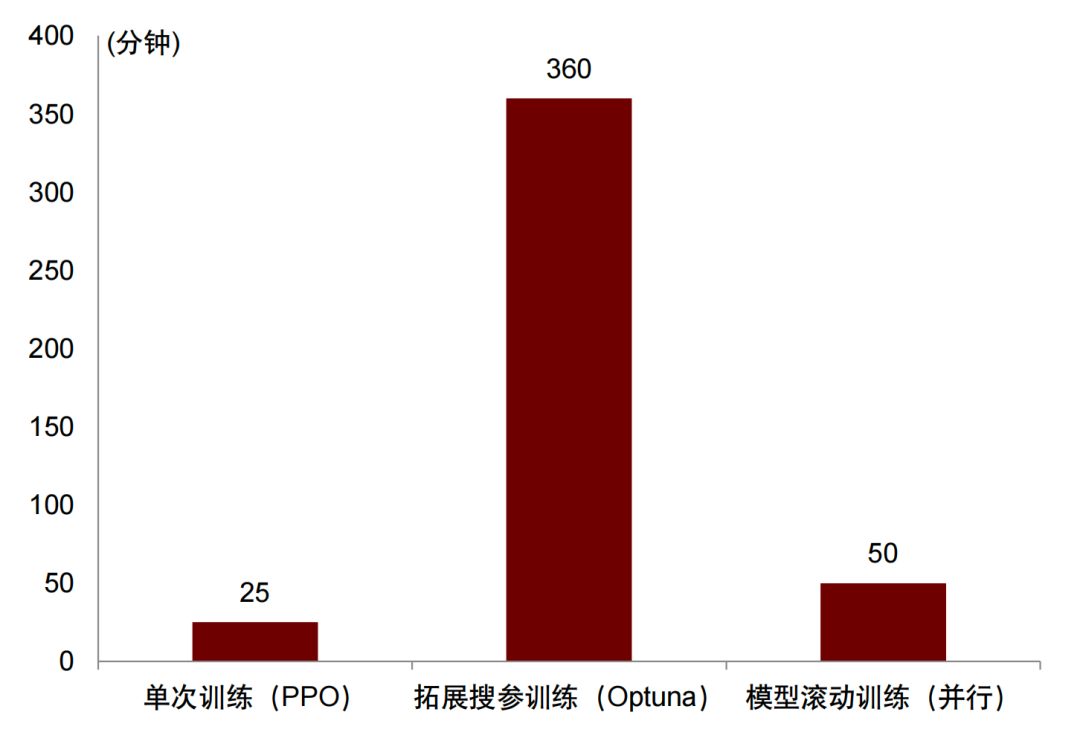

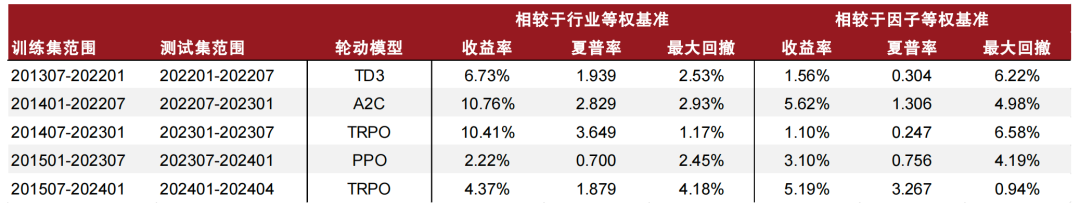

具体的做法和上一节拓展训练的思路类似,我们在样本内区间里对不同的模型进行训练,在仅使用默认参数的情况下选取结果最好的模型在下一阶段进行应用。然后不断重复这一过程,以期找到能够适配新市场环境的模型。假设之一也在于市场环境和适配的模型表现可以在下一期具有一定的持续性。测试结果表面强化学习模型轮动的效果要比单次训练以及拓展样本期训练的表现显著更好,且由于可以并行训练,训练效率远高于拓展搜参模式。

图表34:不同训练框架下的效率对比

注:模型滚动训练效率受限于候选模型中效率最低者,此处为TD3

资料来源:Wind,中金公司研究部

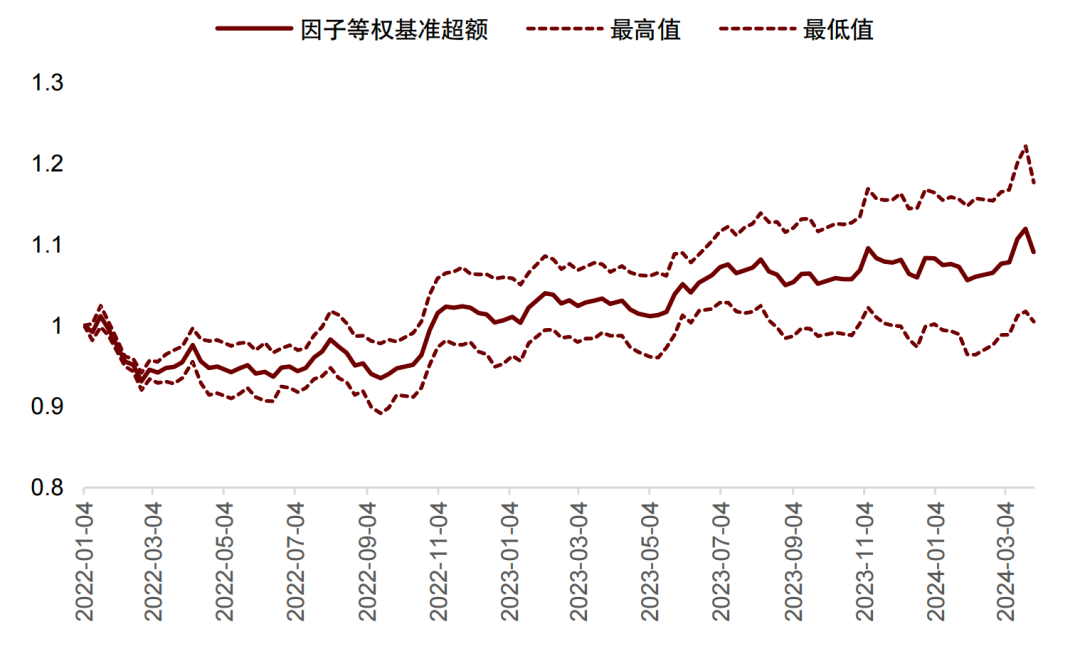

我们发现相较于单次训练的结果,模型滚动的训练在行业和因子等权的超额表现有了显著优势。且多次滚动的样本外因子等权收益率均为正。在2022年后的两年多样本外区间中相对于行业基准超额收益达到16.4%,相对于因子等权基准达7.7%。结果比所有随机数种子下的单次训练以及拓展样本训练的结果都显著更加优越。

上述强化学习模型滚动训练的模式的优势在于能够显著提高模型的多样性和稳定性,减少单一模型在特定任务中的过拟合或欠拟合风险,并通过定期更新模型提升对动态数据的适应性,增强实际操作的价值。然而,这种方法也带来了整体框架复杂性的增加和计算开销的提高,并且在面对数据变化时仍然存在模型失效的风险。综合考虑,这种方法在提升模型性能和适应性方面具有明显优势,但在实际应用中需要平衡系统复杂性和计算成本,并采取有效的措施以降低模型失效的可能性。

图表35:模型轮动模式样本外相较于行业等权基准超额收益净值曲线

资料来源:Wind,中金公司研究部

图表36:模型轮动模式样本外相较于因子等权基准超额收益净值曲线

资料来源:Wind,中金公司研究部

图表37:模型轮动模式样本外表现统计

资料来源:Wind,中金公司研究部

附录

[1]FinRL: Deep reinforcement learning framework to automate trading in quantitative finance.

[2]StockFormer: Learning Hybrid Trading Machines with Predictive Coding. Siyu Gao. 2023

[3]Reinforcement-learning based portfolio management with augmented asset movement prediction states.

[4]“Generating Synergistic Formulaic Alpha Collections via Reinforcement Learning.” Shuo Yu等(2023).

[5]Trust Region Policy Optimization. John Schulman. 2015

[6]Proximal Policy Optimization Algorithms. John Schulman. 2017

版权声明:文章版权归原作者所有,部分文章由作者授权本平台发布,若有其他不妥之处的可与小编联系。

免责声明:

您在阅读本内容或附件时,即表明您已事先接受以下“免责声明”之所载条款:

1、本文内容源于作者对于所获取数据的研究分析,本网站对这些信息的准确性和完整性不作任何保证,对由于该等问题产生的一切责任,本网站概不承担;阅读与私募基金相关内容前,请确认您符合私募基金合格投资者条件。

2、文件中所提供的信息尽可能保证可靠、准确和完整,但并不保证报告所述信息的准确性和完整性;亦不能作为投资决策的依据,不能作为道义的、责任的和法律的依据或者凭证。

3、对于本文以及文件中所提供信息所导致的任何直接的或者间接的投资盈亏后果不承担任何责任;本文以及文件发送对象仅限持有相关产品的客户使用,未经授权,请勿对该材料复制或传播。侵删!

4、所有阅读并从本文相关链接中下载文件的行为,均视为当事人无异议接受上述免责条款,并主动放弃所有与本文和文件中所有相关人员的一切追诉权。